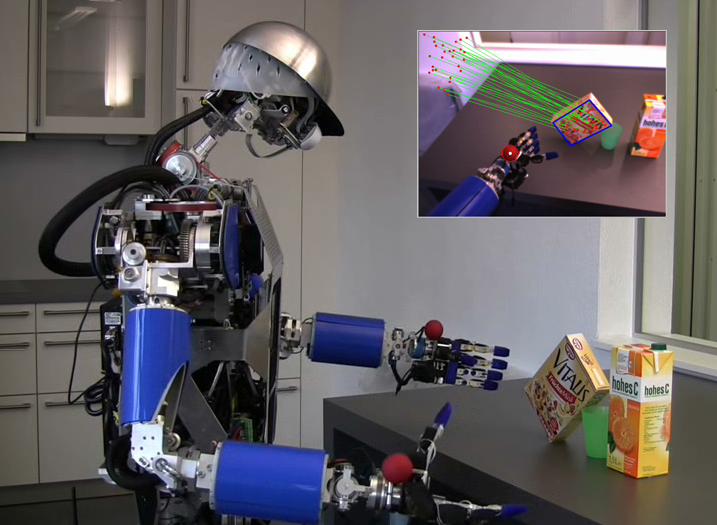

Position-Based Visual Servoing

Damit ein humanoider Roboter zuverlässig greifen und manipulieren kann, muss das System in der Lage sein, Bewegungen robust auszuführen. Die Ausführung wird hierbei von verschiedenen Fehlerquellen beeinflusst, wie z.B. ungenauer Objektlokalisierung, fehlerbehafteten Sensordaten oder einer sich ändernden Umgebung. Es werden Verfahren des Position-Based Visual Servoing (PBVS) genutzt, um robust und reaktiv mit der Umwelt zu interagieren und somit eine zuverlässige Ausführung von Bewegungen zu erreichen. Das Visual Servoing Framework von ARMAR-III fusioniert die Sensordaten aus Motoren, Bildverarbeitung sowie Haptik und ermöglicht es dem Roboter, Objekte und Türgriffe zuverlässig zu greifen. Weiterhin können geplante Trajektorien durch die visuell überwachte Ausführung in komplexen Umgebungen mit hoher Genauigkeit ausgeführt werden.

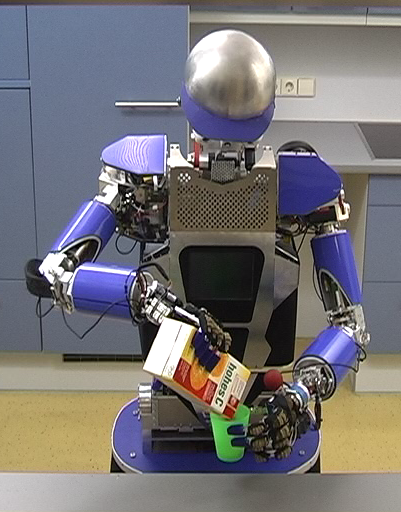

Visual Servoing für zwei Arme

Damit ein humanoider Roboter in der Lage ist, beide Arme zu nutzen und somit seine Fähigkeiten voll auszuschöpfen, müssen zweiarmige Greif- und Manipulationsbewegungen zuverlässig ausgeführt werden können. Das entwickelte Bimanual Visual Servoing Framework ermöglicht es ARMAR-III zweihändige Griffe und Bewegungstrajektorien robust auszuführen. Hierbei wird die Lage des Zielobjekts und/oder beider Hände alternierend ermittelt und eine kombinierte open-/closed-loop Regelung ermöglicht die Positionierung der Hände relativ zu einem Zielobjekt. Die Integration der Daten aus den Kraft-Momentensensoren erlaubt eine reaktive Regelung, welche z.B. bei unerwarteten Kontaktereignissen zu erhöhter Sicherheit führt.

Nullkraftregelung zum Einlernen von Greifpositionen

Der humanoide Roboter ARMAR-III ist in der Lage, Objekte mit einer oder zwei Händen zu greifen. Hierfür muss der Roboter Greifpositionen und Anfahrtsrichtungen kennen. Um diese Daten auf einfache und angenehme Art und Weise einzugeben, können die Hände über Nullkraftregelung von einem menschlichen Benutzer bewegt werden. Hierzu werden die Kraft-/Momentensensoren an den Handgelenken genutzt, um so die Hand entsprechend der Vorgaben zu bewegen. Dies ermöglicht dem Benutzer, die Hand zu objektspezifischen Greifpositionen zu bewegen, und so die Objekt-Hand Relation eines Griffes in einer Datenbank zu speichern.