Aktive visuelle Objektsuche

Um in einer Menschen-zentrierten Umgebung agieren zu können benötigt der humanoide Roboter ARMAR-III die Fähigkeit, sich an Änderungen der Umgebung anpassen zu können. Insbesondere soll der Roboter in der Lage sein, neue Objekte in der Umgebung zu speichern und zu erfassen. Dazu verfolgen wir einen integrierenden Ansatz, der sowohl die Akquisition und Repräsentation von Objektwissen umfasst, als auch dessen Anwendung in Verfahren zur Objekterkennung. Sowohl die Akquisiton von neuem Objektwissen als auch die Erkennung soll dabei zur Laufzeit auf dem System ermöglicht werden. Dabei soll die Fähigkeit der humanoiden Plattform ARMAR-III ausgenutzt werden, aktiv in seine Umgebung einzugreifen, um die visuelle Wahrnehmung zu unterstützen.

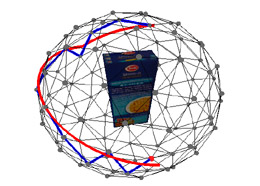

Repräsentationen eines in der Hand des Roboters gehaltenen Objektes werden autonom generiert. Dazu werden mehrere relevante Ansichten des Objektes durch Rotation in der Hand des Roboters erzeugt und aufgenommen. Die Ansichten des Objektes werden mit Hilfe von Verfahren zur Sensordatenfusion sowohl vom Hintergrund als auch von der Roboterhand segmentiert.

Die resultierenden Ansichten werden in Form eines Ansichtsgraphen des Objektes zusammengefasst.

Um den benötigten Speicherbedarf der Objektrepräsentationen zu verringern werden unter Ausnutzung von Ähnlichkeiten prototypische Ansichten für verschiedene Merkmalskanäle erzeugt.

Die resultierenden Objektrepräsentationen werden in der aktiven visuellen Suche eingesetzt. Die humanoide Platform ARMAR-III verfügt über ein foveales und ein peripheres Kamerapaar. Beide Kamerapaare können aktiv über die Freiheitsgrade des Kopfes und der Augen gesteuert werden.

Durch Verarbeitung der peripheren Kamerabilder werden während der visuellen Suche Hypothesen über Positionen einer gesuchten Objektinstanz generiert. Die Hypothesen werden durch fokussieren mit den fovealen Kameras und anschließende Verifikation überprüft. Dazu wird ein top-down Mechanismus zur visuellen Aufmerksamkeit eingesetzt, der die Blickrichtung der fovealen Kameras bestimmt. Die visuellen Informationen, die über mehrere Sakkaden beobachtet werden, werden in einem egozentrischen Szenespeicher akkumuliert. Durch fortlaufende Verifikation wird die Konsistenz und die Persistenz der Informationen im Szenespeicher garantiert.

Repräsentationen eines in der Hand des Roboters gehaltenen Objektes werden autonom generiert. Dazu werden mehrere relevante Ansichten des Objektes durch Rotation in der Hand des Roboters erzeugt und aufgenommen. Die Ansichten des Objektes werden mit Hilfe von Verfahren zur Sensordatenfusion sowohl vom Hintergrund als auch von der Roboterhand segmentiert.

Die resultierenden Ansichten werden in Form eines Ansichtsgraphen des Objektes zusammengefasst.

Um den benötigten Speicherbedarf der Objektrepräsentationen zu verringern werden unter Ausnutzung von Ähnlichkeiten prototypische Ansichten für verschiedene Merkmalskanäle erzeugt.

Die resultierenden Objektrepräsentationen werden in der aktiven visuellen Suche eingesetzt. Die humanoide Platform ARMAR-III verfügt über ein foveales und ein peripheres Kamerapaar. Beide Kamerapaare können aktiv über die Freiheitsgrade des Kopfes und der Augen gesteuert werden.

Durch Verarbeitung der peripheren Kamerabilder werden während der visuellen Suche Hypothesen über Positionen einer gesuchten Objektinstanz generiert. Die Hypothesen werden durch fokussieren mit den fovealen Kameras und anschließende Verifikation überprüft. Dazu wird ein top-down Mechanismus zur visuellen Aufmerksamkeit eingesetzt, der die Blickrichtung der fovealen Kameras bestimmt. Die visuellen Informationen, die über mehrere Sakkaden beobachtet werden, werden in einem egozentrischen Szenespeicher akkumuliert. Durch fortlaufende Verifikation wird die Konsistenz und die Persistenz der Informationen im Szenespeicher garantiert.

Die Implementierung der kompletten Kette von Akquisition über Repräsentation bis zur Suche eines Objektes in der Szene ermöglicht die inkrementelle Erzeugung von visuellem Objekt-bezogenem Wissen. Um dieses Wissen in Manipulationsaufgeben anwenden zu können, wird die Anbindung an die haptische Exploration (siehe ?) vorangetrieben.